Java埋点数据库架构 千万级调用量微服务架构下的数据处理实践

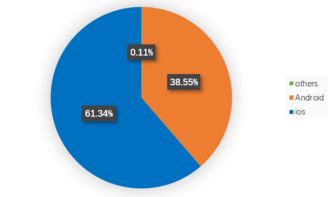

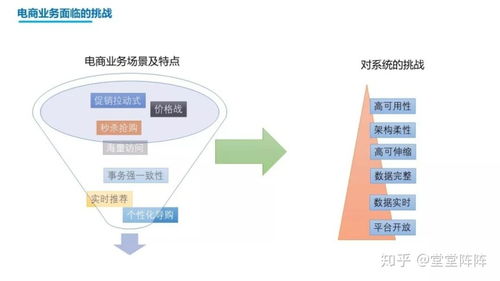

在当今大数据和实时分析驱动的业务环境中,Java埋点数据的处理成为了业务决策和用户体验优化的核心。尤其是在千万级调用量的微服务架构下,如何设计高效、稳定的数据处理服务,是每一位架构师和技术大牛必须面对的挑战。本文将从数据库架构设计、微服务架构实践以及数据处理服务优化三个方面,深入探讨千万级调用量场景下的Java埋点数据处理方案。

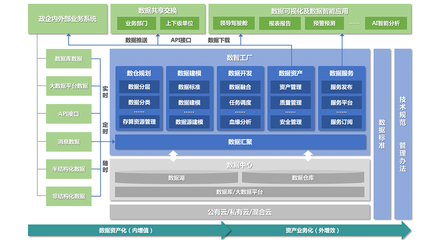

一、Java埋点数据库架构设计

- 数据采集与存储分层

- 在千万级调用量下,数据采集需采用异步和非阻塞的方式,避免对业务服务造成性能影响。常见的做法是使用消息队列(如Kafka)作为数据缓冲层,将埋点数据先写入队列,再由数据处理服务消费。

- 数据库存储方面,采用分层存储策略:原始数据存储在分布式文件系统(如HDFS)或NoSQL数据库(如HBase)中,聚合后的结果数据则存入关系型数据库(如MySQL)或时序数据库(如InfluxDB),以支持快速查询和分析。

- 数据库选型与优化

- 对于高吞吐量的埋点数据,推荐使用列式存储数据库(如ClickHouse)或时序数据库,它们在大规模数据写入和聚合查询上具有显著优势。

- 索引设计是关键,需根据查询模式创建合适的索引,避免全表扫描。同时,通过分库分表策略(如按时间或业务维度分片)来分散读写压力。

- 数据一致性与可靠性

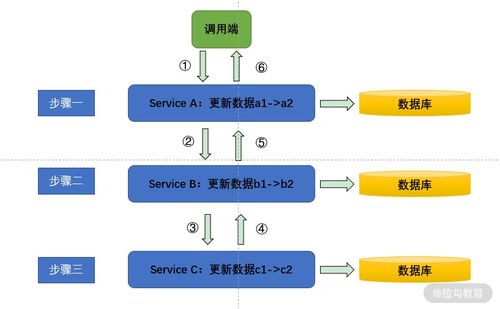

- 采用最终一致性模型,通过消息队列的确认机制和重试策略,确保数据不丢失。对于关键业务数据,可引入事务性消息或分布式事务(如Seata)来保障一致性。

二、千万级调用量微服务架构实践

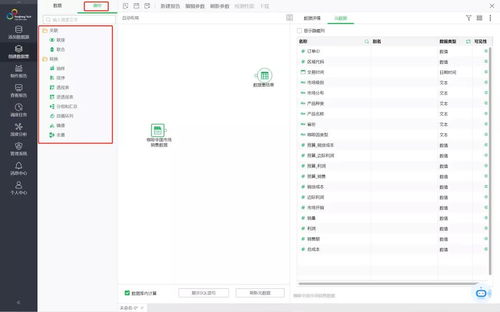

- 微服务拆分与治理

- 将数据处理服务拆分为独立的微服务,如数据采集服务、数据清洗服务、数据聚合服务等,每个服务专注于单一职责,便于水平扩展和维护。

- 使用服务网格(如Istio)或API网关(如Spring Cloud Gateway)进行流量管理、负载均衡和熔断降级,确保系统在高并发下的稳定性。

- 弹性与可扩展性

- 采用容器化部署(如Docker和Kubernetes),结合自动扩缩容策略,根据CPU、内存或自定义指标(如队列积压)动态调整实例数量。

- 利用缓存(如Redis)存储热点数据,减少数据库访问压力,并通过CDN加速静态资源的分发。

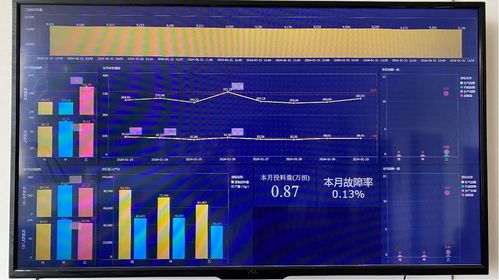

- 监控与告警

- 集成分布式追踪系统(如SkyWalking或Zipkin)和指标监控工具(如Prometheus),实时监控服务性能和数据流状态。设置智能告警规则,及时发现和处理异常。

三、数据处理服务的关键优化点

- 高性能数据处理流水线

- 使用流处理框架(如Apache Flink或Spark Streaming)构建实时数据处理流水线,支持窗口聚合、复杂事件处理和状态管理。

- 优化数据序列化格式(如Avro或Protobuf),减少网络传输和存储开销。

- 资源管理与调度

- 在微服务中,通过线程池、连接池和异步编程模型(如CompletableFuture或Reactor)提升资源利用率。避免阻塞操作,确保系统响应迅速。

- 对于批量处理任务,采用分布式调度框架(如Apache DolphinScheduler)协调任务执行,提高整体吞吐量。

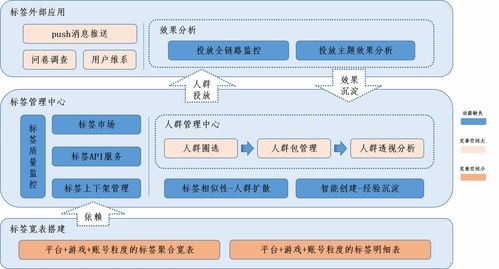

- 数据质量与治理

- 引入数据校验和清洗规则,在数据入口处过滤无效或重复数据。通过数据血缘工具追踪数据流向,保障数据可信度。

- 定期进行数据归档和清理,防止存储膨胀影响性能。

四、大牛的经验分享

在实际项目中,技术大牛们强调以下几点:

- 尽早规划容量:根据业务增长预测,提前进行容量规划,避免系统在流量激增时崩溃。

- 持续性能调优:通过压测和 profiling 工具(如Arthas)识别瓶颈,不断优化代码和配置。

- 自动化运维:利用CI/CD流水线和基础设施即代码(IaC)工具,实现部署和运维的自动化,降低人为错误。

- 容灾与备份:设计多活架构和定期备份策略,确保数据安全和服务高可用。

结语

Java埋点数据处理在千万级调用量的微服务架构下,是一项复杂而关键的任务。通过合理的数据库架构设计、弹性的微服务实践以及高效的数据处理优化,可以构建出稳定、可扩展的数据处理服务。未来,随着边缘计算和AI技术的融合,埋点数据处理将更加智能和实时,为业务创造更大价值。希望本文的实践分享能为您的项目提供参考,助力您在数据洪流中乘风破浪!

如若转载,请注明出处:http://www.zhihongsite.com/product/6.html

更新时间:2026-03-02 22:11:26